文件名称:

模型评估知识点.md

所在目录:

机器学习基础

文件大小:

10.65 KB

下载地址:

文本预览:

# 目录

- [1.Accuracy、Precision、Recall、F1 Scores的相关概念?](#user-content-1.accuracy、precision、recall、f1-scores的相关概念?)

- [2.K折交叉验证逻辑?](#user-content-2.k折交叉验证逻辑?)

- [3.介绍一下机器学习中的信噪比(SNR)](#user-content-3.介绍一下机器学习中的信噪比(SNR))

- [4.混淆矩阵是什么?](#4.混淆矩阵是什么?)

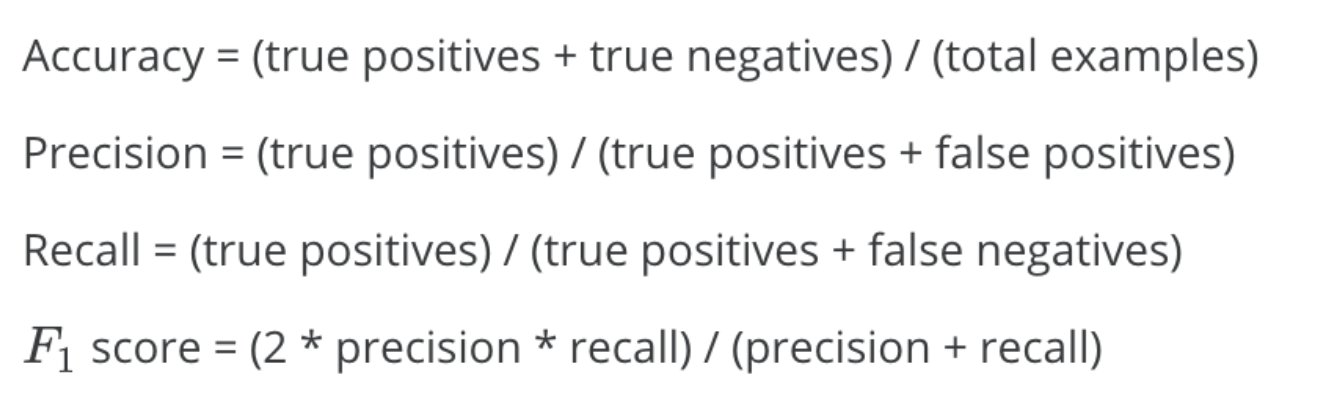

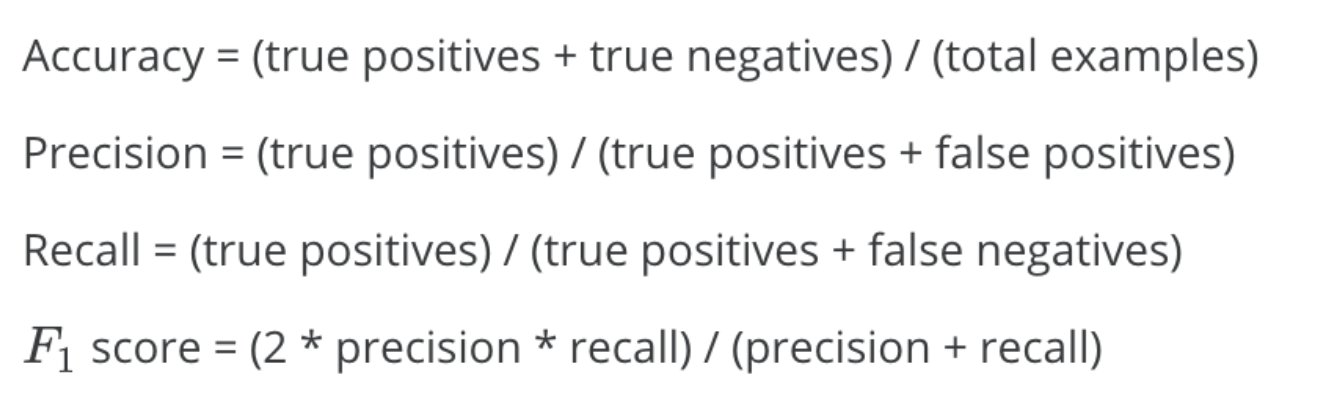

首先Rocky介绍一下相关名词:

1. TP(True Positive): 预测为正,实际为正

2. FP(False Positive): 预测为正,实际为负

3. TN(True Negative):预测为负,实际为负

4. FN(false negative): 预测为负,实际为正

Accuracy、Precision、Recall、F1 Scores的公式如下所示:

Accuracy(准确率):分类正确的样本数占样本总数的比例。

Precision(精准度/查准率):当前预测为正样本类别中被正确分类的样本比例。

Recall(召回率/查全率):预测出来的正样本占正样本总数的比例。

F1-score是Precision和Recall的综合。F1-score越高,说明分类模型越稳健。

### k折交叉验证的作用

当有多个不同的模型(结构不同、超参数不同等)可以选择时,我们通过K折交叉验证来选取对于特定数据集最好的模型。

### k折交叉验证的流程

1. 将含有 $N$ 个样本的数据集,分成 $K$ 份,每份含有 $\frac{N}{K}$ 个样本。选择其中一份作为验证集,另外 $K-1$ 份作为训练集,验证集集就有 $K$ 种情况。

2. 在每种情况中,用训练集训练模型,用验证集测试模型,计算模型的泛化误差。

3. 交叉验证重复 $K$ 次,平均 $K$ 次的结果作为模型最终的泛化误差。

4. $K$ 的取值一般在 $[2,10]$ 之间。 $K$ 折交叉验证的优势在于,同时重复运用随机产生的子样本进行训练和验证, $10$ 折交叉验证是最常用的。

5. 训练集中样本数量要足够多,一般至少大于总样本数的50%。

6. 训练集和验证集必须从完整的数据集中均匀采样。均匀采样的目的是希望减少训练集、验证集与原数据集之间的偏差。当样本数量足够多时,通过随机采样,便可以实现均匀采样的效果。

### 5折交叉验证举例

5折交叉验证(5-fold cross-validation)用来验证从不同的模型中选取最优的模型(最合适的模型)。将数据集分成5份,轮流将其中4份作为训练数据,1份作为验证数据,进行试验。每次试验都会得出相应的正确率。**5次的结果的正确率的平均值作为对算法精度的估计**。同时对不同的模型(如CNN、SVM、LR等)做上述相同的操作,得出每个模型在特定数据集上的平均能力,从中选优。

**例子:**

假设我们有一个特定数据集,我们想从YOLOv4、Mask R-CNN、SSD、Faster R-CNN、RetinaNet这五个模型中选取在这个特定数据集中有最好效果的一个模型作为baseline,我们可以进行交叉验证来进行判断:

**步骤:**

1. 将数据集分成5份。

2. 对于每一个模型,for i = 1, 2, 3, 4,5,每个for循环里将除了第i份的所有数据作为训练集用于训练,得到参数;再将参数在第i份数据上进行验证,得到评价结果。

3. 最后我们可以得到5个模型的结果,每个模型有5个验证结果。将每个模型的结果取平均值,得到该模型的平均结果。

4. 5个模型中平均结果最好的模型就是我们想要的最优模型。

信噪比(Signal-to-Noise Ratio, SNR)在机器学习和数据科学中是一个非常重要的概念,它用于衡量数据中有用信号和噪声的相对大小。通过提高信噪比,数据科学家可以提升数据集的质量,从而优化模型的训练和性能表现。在特征选择、数据预处理、降噪和模型优化等各个环节,信噪比的应用都可以为机器学习过程提供更精确的指导。

### 1. 信噪比的定义

信噪比通常用于表示信号(有用信息)与噪声(不需要的信息)的比例。在数学上,信噪比可以表示为:

$$\text{SNR} = \frac{P_{\text{signal}}}{P_{\text{noise}}}$$

其中:

- $P_{\text{signal}}$ 是信号的功率(或强度),表示有用信息的大小。

- $P_{\text{noise}}$ 是噪声的功率,表示噪声干扰的大小。

信噪比通常以对数形式表示,单位是分贝(dB):

$$\text{SNR(dB)} = 10 \cdot \log_{10} \left(\frac{P_{\text{signal}}}{P_{\text{noise}}}\right)$$

### 2. 信噪比在机器学习中的应用

在机器学习领域,信噪比的概念通常用于衡量数据中有用信息的多少,判断模型训练时是否容易受到噪声的影响。常见应用包括:

#### 2.1 特征选择

信噪比可以帮助我们评估特征是否具有区分能力。高信噪比的特征能够更好地表达数据中的有用信息,而低信噪比的特征则可能受到噪声的干扰,从而影响模型的准确性。

- **信号**:特征与目标变量之间的相关性或信息量。

- **噪声**:特征中随机的或无关的波动,可能干扰模型的学习。

通过计算特征的信噪比,可以选择有用的特征,去除噪声较大的特征,优化模型性能。

#### 2.2 模型训练与优化

在模型训练过程中,数据中的噪声会影响模型的泛化能力。如果数据中的噪声过多,模型可能会过拟合噪声而非学习有用的信号。因此,信噪比高的数据集更容易训练出鲁棒性更高的模型。反之,信噪比低的数据集则可能导致模型性能不稳定。

#### 2.3 数据预处理

在进行数据预处理时,可以通过增强信号或减少噪声的方式来提高信噪比。例如:

- **降噪**:通过滤波器或噪声消除技术降低数据中的随机噪声。

- **平滑处理**:通过平滑技术减少噪声对数据的影响,突出信号。

#### 2.4 图像处理与计算机视觉

在图像处理领域,信噪比常用于评价图像质量。高信噪比的图像具有较清晰的纹理和细节,适合进行图像分类、目标检测等任务;而低信噪比的图像则可能受到噪声干扰,导致模型提取不到关键的特征。

### 3. 如何提高信噪比

在机器学习任务中,我们可以通过多种方法来提高数据的信噪比,从而提升模型性能:

#### 3.1 数据清洗

通过去除异常值、缺失值、重复数据等方式,可以减少噪声,提高数据集的信噪比。

#### 3.2 特征工程

通过选择最具代表性的特征,去除冗余或噪声较大的特征,可以有效提升信噪比。此外,特征缩放、归一化等技术也有助于提高信噪比。

#### 3.3 数据增强

在某些任务中(如图像处理),可以通过生成合成数据(如图像增强技术),来提高信号部分的多样性,从而提升信噪比。

#### 3.4 降噪技术

在处理音频、图像或其他信号数据时,降噪技术(如维纳滤波、小波去噪等)可以有效去除数据中的随机噪声,提升信噪比。

### 4. 信噪比的计算

在实际应用中,信噪比的计算方法可能依赖于具体的领域和任务。以下是几种常见的信噪比计算方法:

#### 4.1 经典信噪比(图像、音频)

对于图像或音频信号,信噪比可以通过原始信号和噪声之间的差异来计算。例如,在图像处理任务中,可以通过比较降噪前后的图像质量来计算:

$$\text{SNR} = 10 \cdot \log_{10} \left(\frac{\sum_{i=1}^N (x_i^2)}{\sum_{i=1}^N (x_i - \hat{x}_i)^2}\right)$$

其中:

- $x_i$ 是原始信号的值,

- $\hat{x}_i$ 是噪声处理后的信号值。

#### 4.2 基于特征的信噪比

在特征选择中,信噪比可以通过特征值的方差来计算。有用信号会导致较大的方差,而噪声则通常会表现为低方差。常用公式为:

$$\text{SNR} = \frac{\sigma_{\text{signal}}^2}{\sigma_{\text{noise}}^2}$$

其中, $\sigma_{\text{signal}}^2$ 是信号部分的方差, $\sigma_{\text{noise}}^2$ 是噪声部分的方差。

### 5. 信噪比的局限性

尽管信噪比是衡量数据质量的一个有效指标,但它也有一些局限性:

- **仅衡量相对比例**:信噪比只能反映信号与噪声的比例,不能单独衡量信号或噪声的绝对值。

- **假设噪声为高斯分布**:很多信噪比的计算方法假设噪声服从高斯分布,但在实际中,噪声的分布可能更加复杂。

混淆矩阵是评估分类模型性能的一个重要工具。它以表格的形式展示了模型预测结果与实际情况的对比,让我们能够直观地看到模型在各个类别上的表现。

最基本的混淆矩阵是针对二分类问题的:

1. 真正例(True Positive, TP): 模型正确地将正例预测为正例。

2. 真负例(True Negative, TN): 模型正确地将负例预测为负例。

3. 假正例(False Positive, FP): 模型错误地将负例预测为正例。

4. 假负例(False Negative, FN): 模型错误地将正例预测为负例。

这四个值组成了2x2的表格,即二分类问题的混淆矩阵。

通过混淆矩阵,我们可以计算出多个重要的评估指标:

- 准确率(Accuracy) = (TP + TN) / (TP + TN + FP + FN)

- 精确率(Precision) = TP / (TP + FP)

- 召回率(Recall) = TP / (TP + FN)

- F1分数 = 2 * (Precision * Recall) / (Precision + Recall)

对于多分类问题,混淆矩阵会相应扩大,变成 n x n 的矩阵,其中n是类别数。

下图显示了一个在基线数据集上使用 VGG16 模型生成的混淆矩阵。这个混淆矩阵用于分析模型在四个类别 (`T5G340`, `H500`, `GXR1`, `W306`) 上的分类性能。混淆矩阵中每个元素的值代表模型在预测某一类时的正确或错误的比例。

- **对角线上的值**(如 `0.9981`, `0.9739`, `0.9032`, `0.9110`)代表模型对这些类别的正确预测比例。例如,对于 `T5G340` 类,模型有 `99.81%` 的样本被正确分类;对于 `H500` 类,正确分类率为 `97.39%`,依此类推。

- **非对角线上的值**表示错误分类的比例。例如,在 `H500` 类的行和 `T5G340` 列中,值为 `0.0078`,这表示有 `0.78%` 的 `H500` 类样本被错误地分类为 `T5G340` 类。类似地,`0.0366` 表示有 `3.66%` 的 `GXR1` 类样本被错误分类为 `H500` 类。

- [1.Accuracy、Precision、Recall、F1 Scores的相关概念?](#user-content-1.accuracy、precision、recall、f1-scores的相关概念?)

- [2.K折交叉验证逻辑?](#user-content-2.k折交叉验证逻辑?)

- [3.介绍一下机器学习中的信噪比(SNR)](#user-content-3.介绍一下机器学习中的信噪比(SNR))

- [4.混淆矩阵是什么?](#4.混淆矩阵是什么?)

1.Accuracy、Precision、Recall、F1 Scores的相关概念?

首先Rocky介绍一下相关名词:

1. TP(True Positive): 预测为正,实际为正

2. FP(False Positive): 预测为正,实际为负

3. TN(True Negative):预测为负,实际为负

4. FN(false negative): 预测为负,实际为正

Accuracy、Precision、Recall、F1 Scores的公式如下所示:

Accuracy(准确率):分类正确的样本数占样本总数的比例。

Precision(精准度/查准率):当前预测为正样本类别中被正确分类的样本比例。

Recall(召回率/查全率):预测出来的正样本占正样本总数的比例。

F1-score是Precision和Recall的综合。F1-score越高,说明分类模型越稳健。

2.K折交叉验证逻辑?

### k折交叉验证的作用

当有多个不同的模型(结构不同、超参数不同等)可以选择时,我们通过K折交叉验证来选取对于特定数据集最好的模型。

### k折交叉验证的流程

1. 将含有 $N$ 个样本的数据集,分成 $K$ 份,每份含有 $\frac{N}{K}$ 个样本。选择其中一份作为验证集,另外 $K-1$ 份作为训练集,验证集集就有 $K$ 种情况。

2. 在每种情况中,用训练集训练模型,用验证集测试模型,计算模型的泛化误差。

3. 交叉验证重复 $K$ 次,平均 $K$ 次的结果作为模型最终的泛化误差。

4. $K$ 的取值一般在 $[2,10]$ 之间。 $K$ 折交叉验证的优势在于,同时重复运用随机产生的子样本进行训练和验证, $10$ 折交叉验证是最常用的。

5. 训练集中样本数量要足够多,一般至少大于总样本数的50%。

6. 训练集和验证集必须从完整的数据集中均匀采样。均匀采样的目的是希望减少训练集、验证集与原数据集之间的偏差。当样本数量足够多时,通过随机采样,便可以实现均匀采样的效果。

### 5折交叉验证举例

5折交叉验证(5-fold cross-validation)用来验证从不同的模型中选取最优的模型(最合适的模型)。将数据集分成5份,轮流将其中4份作为训练数据,1份作为验证数据,进行试验。每次试验都会得出相应的正确率。**5次的结果的正确率的平均值作为对算法精度的估计**。同时对不同的模型(如CNN、SVM、LR等)做上述相同的操作,得出每个模型在特定数据集上的平均能力,从中选优。

**例子:**

假设我们有一个特定数据集,我们想从YOLOv4、Mask R-CNN、SSD、Faster R-CNN、RetinaNet这五个模型中选取在这个特定数据集中有最好效果的一个模型作为baseline,我们可以进行交叉验证来进行判断:

**步骤:**

1. 将数据集分成5份。

2. 对于每一个模型,for i = 1, 2, 3, 4,5,每个for循环里将除了第i份的所有数据作为训练集用于训练,得到参数;再将参数在第i份数据上进行验证,得到评价结果。

3. 最后我们可以得到5个模型的结果,每个模型有5个验证结果。将每个模型的结果取平均值,得到该模型的平均结果。

4. 5个模型中平均结果最好的模型就是我们想要的最优模型。

3.介绍一下机器学习中的信噪比(SNR)

信噪比(Signal-to-Noise Ratio, SNR)在机器学习和数据科学中是一个非常重要的概念,它用于衡量数据中有用信号和噪声的相对大小。通过提高信噪比,数据科学家可以提升数据集的质量,从而优化模型的训练和性能表现。在特征选择、数据预处理、降噪和模型优化等各个环节,信噪比的应用都可以为机器学习过程提供更精确的指导。

### 1. 信噪比的定义

信噪比通常用于表示信号(有用信息)与噪声(不需要的信息)的比例。在数学上,信噪比可以表示为:

$$\text{SNR} = \frac{P_{\text{signal}}}{P_{\text{noise}}}$$

其中:

- $P_{\text{signal}}$ 是信号的功率(或强度),表示有用信息的大小。

- $P_{\text{noise}}$ 是噪声的功率,表示噪声干扰的大小。

信噪比通常以对数形式表示,单位是分贝(dB):

$$\text{SNR(dB)} = 10 \cdot \log_{10} \left(\frac{P_{\text{signal}}}{P_{\text{noise}}}\right)$$

### 2. 信噪比在机器学习中的应用

在机器学习领域,信噪比的概念通常用于衡量数据中有用信息的多少,判断模型训练时是否容易受到噪声的影响。常见应用包括:

#### 2.1 特征选择

信噪比可以帮助我们评估特征是否具有区分能力。高信噪比的特征能够更好地表达数据中的有用信息,而低信噪比的特征则可能受到噪声的干扰,从而影响模型的准确性。

- **信号**:特征与目标变量之间的相关性或信息量。

- **噪声**:特征中随机的或无关的波动,可能干扰模型的学习。

通过计算特征的信噪比,可以选择有用的特征,去除噪声较大的特征,优化模型性能。

#### 2.2 模型训练与优化

在模型训练过程中,数据中的噪声会影响模型的泛化能力。如果数据中的噪声过多,模型可能会过拟合噪声而非学习有用的信号。因此,信噪比高的数据集更容易训练出鲁棒性更高的模型。反之,信噪比低的数据集则可能导致模型性能不稳定。

#### 2.3 数据预处理

在进行数据预处理时,可以通过增强信号或减少噪声的方式来提高信噪比。例如:

- **降噪**:通过滤波器或噪声消除技术降低数据中的随机噪声。

- **平滑处理**:通过平滑技术减少噪声对数据的影响,突出信号。

#### 2.4 图像处理与计算机视觉

在图像处理领域,信噪比常用于评价图像质量。高信噪比的图像具有较清晰的纹理和细节,适合进行图像分类、目标检测等任务;而低信噪比的图像则可能受到噪声干扰,导致模型提取不到关键的特征。

### 3. 如何提高信噪比

在机器学习任务中,我们可以通过多种方法来提高数据的信噪比,从而提升模型性能:

#### 3.1 数据清洗

通过去除异常值、缺失值、重复数据等方式,可以减少噪声,提高数据集的信噪比。

#### 3.2 特征工程

通过选择最具代表性的特征,去除冗余或噪声较大的特征,可以有效提升信噪比。此外,特征缩放、归一化等技术也有助于提高信噪比。

#### 3.3 数据增强

在某些任务中(如图像处理),可以通过生成合成数据(如图像增强技术),来提高信号部分的多样性,从而提升信噪比。

#### 3.4 降噪技术

在处理音频、图像或其他信号数据时,降噪技术(如维纳滤波、小波去噪等)可以有效去除数据中的随机噪声,提升信噪比。

### 4. 信噪比的计算

在实际应用中,信噪比的计算方法可能依赖于具体的领域和任务。以下是几种常见的信噪比计算方法:

#### 4.1 经典信噪比(图像、音频)

对于图像或音频信号,信噪比可以通过原始信号和噪声之间的差异来计算。例如,在图像处理任务中,可以通过比较降噪前后的图像质量来计算:

$$\text{SNR} = 10 \cdot \log_{10} \left(\frac{\sum_{i=1}^N (x_i^2)}{\sum_{i=1}^N (x_i - \hat{x}_i)^2}\right)$$

其中:

- $x_i$ 是原始信号的值,

- $\hat{x}_i$ 是噪声处理后的信号值。

#### 4.2 基于特征的信噪比

在特征选择中,信噪比可以通过特征值的方差来计算。有用信号会导致较大的方差,而噪声则通常会表现为低方差。常用公式为:

$$\text{SNR} = \frac{\sigma_{\text{signal}}^2}{\sigma_{\text{noise}}^2}$$

其中, $\sigma_{\text{signal}}^2$ 是信号部分的方差, $\sigma_{\text{noise}}^2$ 是噪声部分的方差。

### 5. 信噪比的局限性

尽管信噪比是衡量数据质量的一个有效指标,但它也有一些局限性:

- **仅衡量相对比例**:信噪比只能反映信号与噪声的比例,不能单独衡量信号或噪声的绝对值。

- **假设噪声为高斯分布**:很多信噪比的计算方法假设噪声服从高斯分布,但在实际中,噪声的分布可能更加复杂。

4.混淆矩阵是什么?

混淆矩阵是评估分类模型性能的一个重要工具。它以表格的形式展示了模型预测结果与实际情况的对比,让我们能够直观地看到模型在各个类别上的表现。

最基本的混淆矩阵是针对二分类问题的:

1. 真正例(True Positive, TP): 模型正确地将正例预测为正例。

2. 真负例(True Negative, TN): 模型正确地将负例预测为负例。

3. 假正例(False Positive, FP): 模型错误地将负例预测为正例。

4. 假负例(False Negative, FN): 模型错误地将正例预测为负例。

这四个值组成了2x2的表格,即二分类问题的混淆矩阵。

通过混淆矩阵,我们可以计算出多个重要的评估指标:

- 准确率(Accuracy) = (TP + TN) / (TP + TN + FP + FN)

- 精确率(Precision) = TP / (TP + FP)

- 召回率(Recall) = TP / (TP + FN)

- F1分数 = 2 * (Precision * Recall) / (Precision + Recall)

对于多分类问题,混淆矩阵会相应扩大,变成 n x n 的矩阵,其中n是类别数。

下图显示了一个在基线数据集上使用 VGG16 模型生成的混淆矩阵。这个混淆矩阵用于分析模型在四个类别 (`T5G340`, `H500`, `GXR1`, `W306`) 上的分类性能。混淆矩阵中每个元素的值代表模型在预测某一类时的正确或错误的比例。

- **对角线上的值**(如 `0.9981`, `0.9739`, `0.9032`, `0.9110`)代表模型对这些类别的正确预测比例。例如,对于 `T5G340` 类,模型有 `99.81%` 的样本被正确分类;对于 `H500` 类,正确分类率为 `97.39%`,依此类推。

- **非对角线上的值**表示错误分类的比例。例如,在 `H500` 类的行和 `T5G340` 列中,值为 `0.0078`,这表示有 `0.78%` 的 `H500` 类样本被错误地分类为 `T5G340` 类。类似地,`0.0366` 表示有 `3.66%` 的 `GXR1` 类样本被错误分类为 `H500` 类。

点赞

回复

X